Los modelos de Inteligencia Artificial (IA) podrían enfrentarse pronto a un nuevo problema a medida que los contenidos generados por IA se propaguen cada vez más por Internet. Los grandes modelos lingüísticos (LLM), como ChatGPT de OpenAI, se han basado en los datos disponibles en línea para entrenar y mejorar sus modelos.

Sin embargo, a medida que estos modelos agotan los datos disponibles en línea o se enfrentan amayores restricciones en el acceso a los datos, pueden entrenarse con contenidos generados por la IA.

Según un nuevo estudio, esto podría dar lugar a una degradación del rendimiento de los modelos y, en última instancia, provocaría la producción de contenidos incoherentes, un fenómeno conocido como 'colapso del modelo'.

"Con el tiempo, prevemos que será más difícil entrenar los modelos, aunque probablemente tengamos más datos, simplemente porque es muy fácil tomar muestras de los datos de los modelos", explica a 'Euronews Next (LON:NXT)' Ilia Shumailov, investigador junior de la Universidad de Oxford y coautor del estudio.

Va a ser más difícil encontrar una población de datos que no esté realmente sesgadaIlia Shumailov Investigador junior de la Universidad de Oxford

"Pero lo que va a ocurrir es que va a ser más difícil encontrar una población de datos que no esté realmente sesgada", añadió. El estudio, publicado en la revista 'Nature', analiza lo que ocurre cuando los modelos se entrenan con datos generados por IA a lo largo de múltiples ciclos.

La investigación descubrió que los sistemas empiezan a cometer errores significativos y caen en el sinsentido. Otro artículo de Emily Wenger, investigadora de la Universidad de Duke, lo demuestra mediante un experimento en el que un modelo de IA se entrena continuamente con contenidos generados por la IA.

En el experimento, se proporcionó a un modelo de IA un conjunto de datos que contenía fotos de diferentes razas de perros, con una sobrerrepresentación de golden retrievers.

El estudio descubrió que era más probable que el modelo generara imágenes de golden retrievers que de otras razas de perros menos representadas. A medida que avanzaba el ciclo, el modelo fue dejando de lado otras razas hasta que empezó a generar imágenes sin sentido.

Etapas del 'colapso del modelo' en la Inteligencia Artificial

"El colapso del modelo tiene dos etapas. La primera es lo que llamamos la etapa inicial del colapso del modelo, y lo que ocurre es que cuando un modelo aprende de otro, lo primero que se observa es una reducción de la varianza", explica Shumailov.Esto da lugar a un sobremuestreo de determinados aspectos, mientras que se descuidan otros importantes simplemente porque no estaban del todo claros para el modelo inicial.

Es cuando los modelos de IA dejan de ser útiles debido a que los modelos anteriores introducen sus propios errores en los datos. Los errores presentes en los datos iniciales pasan al siguiente modelo, que añade su propio conjunto de errores y lo transmite también.

Como los datos se producen y reciclan continuamente, los modelos empiezan a malinterpretar la realidad y a cometer más errores.

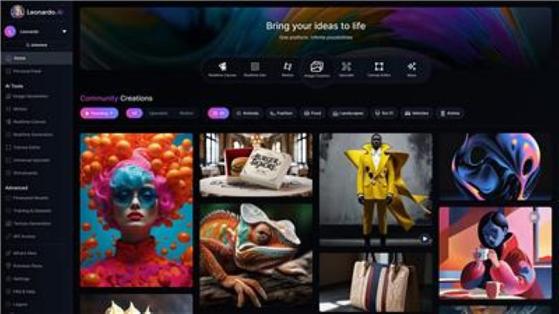

Galegría de imágenes generadas por Inteligencia Artificial. AP Photo

"Si hay algunos errores dentro de los datos que fueron generados por el modelo uno, básicamente se propagan al siguiente modelo. Y, en última instancia, el resultado es que el modelo básicamente malinterpreta la realidad", explica Shumailov.

Tipos de errores de los modelos de IA

Según Shumailov, hay tres tipos de errores que pueden cometer los modelos: errores de arquitectura, errores del proceso de aprendizaje y errores estadísticos.Los errores de arquitectura se producen cuando la estructura del modelo de IA no es la adecuada para captar todas las complejidades de los datos que se le proporcionan, lo que provoca imprecisiones porque el modelo malinterpreta o simplifica en exceso algunas partes.

Los errores del proceso de aprendizaje se producen cuando los métodos utilizados para entrenar los modelos tienen sesgos inherentes, lo que empuja al modelo a cometer ciertos tipos de errores.

Implicaciones del 'colapso del modelo'

Cuando los modelos se colapsan, la principal preocupación es que se ralentice el ritmo de mejora de su rendimiento. Los modelos de IA dependen en gran medida de la calidad de los datos con los que se entrenan.Sin embargo, cuando se entrenan con contenidos generados por la IA, estos datos introducen continuamente errores en el sistema.

"Es probable que tengamos que dedicar un esfuerzo adicional a filtrar los datos. Y esto probablemente suponga una ralentización de la mejora", afirma Shumailov.

Además, a medida que disminuye la varianza y los datos se vuelven menos diversos, se espera que los datos infrarrepresentados se vean afectados de forma desproporcionada, lo que plantea dudas sobre la inclusividad de los modelos de IA.

"Tenemos que ser extremadamente cuidadosos para asegurarnos de que nuestros modelos son justos y no pierden de vista los datos de las minorías que contienen", afirma Shumailov.